Os campos de inteligência artificial e aprendizagem automática estão se expandindo tão rapidamente que as noções de ética estão ficando para trás, ou sendo deixadas para as obras de ficção científica. Isso parece explicar a realização de um novo estudo da Universidade Shanghai Jiao Tong, na China, que alega que computadores podem determinar se um indivíduo vai se tornar um criminoso baseado em nada além de suas feições.

A esperança frustrada de tentar inferir traços de moralidade a partir da psicologia foi perseguida por centenas de anos, em especial, por indivíduos que esperavam justificar a supremacia étnica de um grupo específico. Mas a frenologia, que estudava o crânio para estabelecer níveis de caráter e inteligência, foi desmistificada na época da Revolução Industrial, quando poucas pessoas além dos adeptos da pseudociência ainda defendiam que o formato da boca ou extensão das pálpebras poderia determinar se uma pessoa viria a se tornar um estuprador ou um ladrão.

Mas, aparentemente, o mesmo não vale para a era moderna da inteligência artificial: em um artigo chamado”Inferência automatizada de criminalidade através de imagens de rostos”, dois pesquisadores da Universidade Shanghai Jiao Tong disseram que carregaram “imagens faciais de 1.856 pessoas” em computadores e descobriram “atributos estruturais distintos que identificam traços de criminalidade, como a curvatura labial, a distância entre as córneas internas e o ângulo entre a boca e o nariz”. Os pesquisadores concluíram que “as quatro classificações têm resultados razoavelmente consistentes e confirmam a validade da inferência de criminalidade automatizada baseada nas feições, embora o assunto seja historicamente polêmico”.

Apesar de ter sido rejeitada há muito tempo pela comunidade científica, a frenologia e outras formas de fisiognomia reapareceram em alguns momentos sombrios da história. Esse artigo publicado em 2009 no site Pacific Standard sobre os horrores do racismo na Ruanda colonial poderia ter servido de inspiração para os pesquisadores:

Nos anos 20 e 30, os belgas, na posição de colonizadores, criaram um programa nacional para tentar identificar a origem étnica de certos indivíduos através da frenologia, uma tentativa frustrada de criar uma escala étnica com base em traços físicos mensuráveis, como altura, peso e largura do nariz, na esperança de que os administradores das colônias não precisassem exigir cartões de identidade.

Isso é extremamente grave: os autores dessa pesquisa — em pleno 2016 — acreditam que computadores são capazes de detectar a propensão à criminalidade escaneando imagens de lábios, olhos e narizes. Essa pesquisa deixa a frenologia no chinelo.

Tradução: (a) Três amostras do conjunto Sc de fotos de criminosos (b) Três amostras do conjunto Sn de fotos de não criminosos Figura 1. Amostras de fotos de identificação de nosso arquivo

O estudo praticamente não discute por que há uma “polêmica histórica” sobre esse tipo de análise, que comprovou-se infundada há centenas de anos. Muito pelo contrário, os autores invocam outro argumento falso para justificar suas principais conclusões; dizem que computadores não podem ser racistas, pois são computadores:

Diferente de um avaliador/examinador humano, o algoritmo ou classificador do computador não tem nenhuma bagagem subjetiva, emoções ou preconceitos baseados em experiências passadas com etnia, religião, ideologia política, sexo, idade, etc. Não apresenta cansaço mental e não reage a ter dormido ou comido mal. A inferência automatizada de criminalidade elimina por completo a variável da meta-precisão (a competência do avaliador/examinador humano). Além da vantagem da objetividade, algoritmos sofisticados baseados em aprendizado de máquina podem descobrir nuances sutis e elusivas nos atributos e estruturas faciais associadas a traços de personalidade inatos, que passariam desapercebidas para um leigo sem treinamento.

Além disso, não é mencionado em nenhum ponto da pesquisa se esse software pode ser usado de forma abusiva por parte das agências de segurança. Kate Crawford, pesquisadora de IA do Microsoft Research New York, MIT e NYU, contou ao The Intercept que “chamaria essa pesquisa de frenologia pura. A única diferença é que estão usando ferramentas modernas de aprendizado automático supervisionado, em vez de paquímetros”.

Crawford alertou que, “à medida que entramos em uma era de policiais com câmeras de corpo e policiamento preditivo – baseado em prever fatos – é importante analisar de forma crítica o uso problemático e antiético de aprendizado automático para estabelecer correlações espúrias”, acrescentando ser evidente que os autores “sabem dos problemas éticos e científicos da pesquisa, mas a “curiosidade” foi mais forte”.

Temos uma oportunidade, e ela pode ser a última:

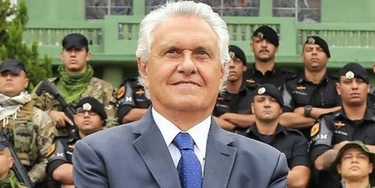

Colocar Bolsonaro e seus comparsas das Forças Armadas atrás das grades.

Ninguém foi punido pela ditadura militar, e isso abriu caminho para uma nova tentativa de golpe em 2023. Agora que os responsáveis por essa trama são réus no STF — pela primeira e única vez — temos a chance de quebrar esse ciclo de impunidade!

Estamos fazendo nossa parte para mudar a história, investigando e expondo essa organização criminosa — e seu apoio é essencial durante o julgamento!

Precisamos de 800 novos doadores mensais até o final de abril para seguir produzindo reportagens decisivas para impedir o domínio da máquina bilionária da extrema direita. É a sua chance de mudar a história!

Torne-se um doador do Intercept Brasil e garanta que Bolsonaro e sua gangue golpista não tenham outra chance de atacar nossos direitos.