Todo ano, o Facebook reúne centenas de desenvolvedores, parceiros de negócios e jornalistas para o discurso do diretor executivo da empresa, Mark Zuckerberg, sobre a sua visão de futuro. O encontro é conhecido como “F8”, e a edição deste ano trouxe alguns planos radicais, um dos quais parece saído de um livro de ficção científica: o uso do cérebro humano como dispositivo de entrada de dados.

Embora ainda esteja muito longe de torná-la realidade, o Facebook deveria publicamente levar em consideração as sérias implicações dessa tecnologia.

Há poucos detalhes sobre como esse projeto de interface cérebro-máquina funcionaria, provavelmente porque a empresa ainda não o inventou. Mas a verdade é que ela já tem pesquisado seriamente sobre suas possíveis aplicações. Isso fica claro no seguinte press release:

“Adotamos uma abordagem bem diferente no campo da interface cérebro-máquina e de reconhecimento de voz. É uma abordagem mais científica e não invasiva”, afirma a companhia. O projeto é descrito como “uma interface silenciosa de reconhecimento do discurso, com a velocidade e flexibilidade da fala e a privacidade do texto”. O objetivo é ser capaz de processar “cem palavras por minuto, extraídas diretamente do centro da fala do cérebro”. Isso seria possível por meio de “sensores não invasivos distribuídos em larga escala (…), e um mapeamento ótico dos neurônios, capaz de analisar a atividade cerebral centenas de vezes por segundo”.

“A privacidade do texto” é uma expressão interessante vinda do Facebook, que, assim como o Google, se tornou uma empresa multibilionária com base no uso de textos digitados no computador para direcionar a ação publicitária. Para desenvolver essa interface entre pensamento e máquina, o Facebook diz ter montado uma equipe “de mais de 60 cientistas, engenheiros e integradores de sistemas” de algumas das mais conceituadas universidades americanas (encabeçada pelo ex-diretor da DARPA –Agência de Projetos de Pesquisa Avançada de Defesa). A questão da privacidade foi uma das primeiras perguntas dos jornalistas presentes no F8, como mostra o seguinte trecho de um artigo do portal The Verge:

“[A diretora de pesquisa do Facebook] Regina Dugan ressalta que não se trata de invadir a mente de ninguém – uma ressalva importante, visto a preocupação do público com a questão da violação de privacidade envolvendo grandes redes sociais como o Facebook. ‘Trata-se de decodificar as palavras que você já decidiu compartilhar ao enviá-las para o centro da fala do seu cérebro’, afirma ela, no anúncio oficial da empresa. ‘Por exemplo, você tira várias fotos mas decide compartilhar apenas algumas delas. Da mesma forma, você tem vários pensamentos e decide compartilhar apenas alguns’, explica.”

O Facebook tinha visivelmente se preparado para enfrentar perguntas sobre a questão da privacidade no uso do cérebro como fonte de dados. Assim, nada mais natural do que perguntar se essa tecnologia ainda incipiente também faria parte da gigantesca máquina de publicidade da empresa. E foi exatamente o que perguntei ao Facebook no mesmo dia em que o projeto foi anunciado: a empresa pode se comprometer desde já a não utilizar a atividade cerebral dos usuários para fins de publicidade?

Ha Thai, porta-voz da companhia, respondeu:

“Estamos desenvolvendo uma interface que permite ao usuário se comunicar com a velocidade e a flexibilidade da voz e a privacidade do texto. Ou seja, será usado apenas o conteúdo que o usuário já decidiu compartilhar, enviando-o ao centro da fala do cérebro. A privacidade estará incluída no sistema, como em todas as ações do Facebook.”

Como aquilo não respondia à pergunta, eu insisti:

“Minha pergunta é a seguinte: o Facebook pode se comprometer desde já a não utilizar a atividade cerebral dos usuários para fins de publicidade?”

“Sam, essa é a melhor resposta que posso dar no momento”, respondeu Thai.

Tudo bem, mas isso quer dizer que não, o Facebook não pode garantir, pelo menos no momento, que não vai usar a atividade cerebral dos usuários para a venda de publicidade. Também não quer dizer que a empresa vai necessariamente fazer isso, é claro, mas o que importa é que o Facebook não descarta a possibilidade. Mas também é possível que esse “neuroteclado” não passe de uma jogada de marketing, um vaporware, como o drone de entregas da Amazon ou o transmissor de dados voador movido a energia solar do próprio Facebook.

Embora essa tecnologia ainda esteja longe de virar realidade, a preocupação com a privacidade dos usuários não é exagerada. Não devemos ignorar o histórico de experimentos da empresa com a mente dos usuários, seja manipulando suas emoções ou colocando imagens das pessoas em anúncios sem o consentimento delas. “Eles confiam em mim, os idiotas”, brincou Zuckerberg com um amigo, via mensagem, quando ainda estava desenvolvendo o Facebook em seu dormitório em Harvard.

O interesse do Facebook pela digitação mental foi notado por especialistas em Neuroética. Para eles, isso reforça a ideia de que o avanço das tecnologias de interface cérebro-computador (BCI, na sigla em inglês) vai transformar em realidade o que antes era coisa de ficção científica.

“Acho preocupante que não haja muita reflexão sobre o que significa perder o controle de uma zona de privacidade”, diz o dr. Eran Klein, professor de Neurologia da Oregan Health and Sciences University e especialista em Neuroética do Centro de Neuroengenharia Sensório-Motora. “Uma das coisas que nos faz humanos é poder decidir o que sai da nossa boca e o que deixar guardado na cabeça”, afirma.

Um vazamento acidental de nossos monólogos interiores para servidores online poderia ter profundas consequências. “Se você tem um preconceito mas se esforça para refreá-lo, isso é sinal de caráter. Porém, por causa daquele prático ‘neuroteclado’ que você comprou, seus preconceitos podem ficar escancarados para todo mundo. Isso mudaria totalmente a maneira pela qual avaliamos o caráter e as escolhas morais das pessoas”, diz Klein.

Poder não dizer tudo o que nos passa pela cabeça é fundamental para a humanidade, a sociedade e a moral, e o Facebook já desrespeitou esse direito no passado. Em 2013, o Facebook publicou um estudo que detalhava como a empresa estava armazenando não apenas textos publicados no site, mas também aqueles que por alguma razão haviam sido deletados pelos usuários antes de publicados. Segundo os autores, o Facebook “perde valor com a falta de geração de conteúdo” nesses casos, classificados como “autocensura”. Será que podemos confiar em uma companhia que não sabe respeitar a intimidade de um pensamento, entregando a ela uma conexão direta com o nosso cérebro?

A promessa de que os usuários poderão facilmente determinar o que deve ou não ser transmitido para os servidores do Facebook parece plausível para Klein, mas com uma ressalva: uma característica intrínseca da fala é que não precisamos pensar em cada palavra antes de pronunciá-la. “Quando estou conversando, não aparece nenhuma janela na minha cabeça com botões de ‘sim’ ou ‘não’ para me ajudar a decidir que palavras usar”, explica. A maneira pela qual o projeto foi anunciado dá a impressão de que o cérebro funciona da mesma maneira simples que os ajustes de privacidade do próprio Facebook. “Mas seria muito cansativo ter que tomar uma decisão para cada palavra de uma fala”, afirma Klein. Segundo ele, isso acarretaria o que os neurologistas chamam de “sobrecarga cognitiva.”

Portanto, em vez de uma alternância constante e consciente entre pensamentos públicos e privados, para o cientista “só seria possível integrar essa tecnologia ao nosso dia-a-dia apelando para o subconsciente”. Se esse for o caso, a analogia com o compartilhamento seletivo de fotos do Facebook perderia a validade. “Porque a escolha deixaria de ser consciente”, argumenta. Para Klein, haveria um paradoxo na questão: para que a tecnologia fosse útil, teria que subconsciente, o que eliminaria a possibilidade de controle absoluto da própria privacidade que foi descrita pela porta-voz do Facebook.

Howard Chizeck é especialista em Neuroética e professor de Engenharia Elétrica da Universidade de Washington, onde também codirige o laboratório de Biorrobótica. Assim como Klein, Chizeck acha que o Facebook pode estar superestimando – ou simplificando demais – a capacidade do cérebro de entrar conscientemente em uma espécie de “modo privado”. “Duvido que possamos escolher exatamente que palavras ‘pensar’ para um sistema externo, pois os pensamentos verbais também ocorrem de maneira espontânea”, pondera.

Chizeck acrescenta que tal atividade “pode variar de pessoa para pessoa e em diferentes condições, como quando bebemos ou estamos cansados”, o que pode dificultar ainda mais o projeto do Facebook. Mesmo que seja possível selecionar precisamente os pensamentos destinados à fala, haveria o risco de vazamento de outros pensamentos para dentro dos servidores do Facebook, segundo Chizeck. “Mesmo que seja possível visualizar as palavras que desejamos enviar, outros sinais cerebrais também podem ser monitorados, o que é preocupante do ponto de vista da privacidade”, afirma.

Quanto ao potencial publicitário do projeto e outras possibilidades assustadoras, Klein acha que não é cedo demais para exigir respostas sérias do Facebook sobre suas pesquisas. “A empresa deve dar garantias de transparência com relação ao que está sendo gravado e como isso pode ser usado na publicidade, mesmo que a pesquisa ainda esteja apenas começando”, diz o professor.

A necessidade de otimizar e conectar o sistema ao subconsciente torna a questão da publicidade ainda mais problemática. “Se for subconsciente, quer dizer que não temos consciência da informação que está chegando até a empresa. Isso significa que o Facebook poderia direcionar a uma pessoa anúncios de produtos de que nem ela mesma sabia que gostava”, pondera Klein.

Tanto Klein quanto Chizeck afirmam que o Facebook deveria, em vez de deixar para depois a questão óbvia da privacidade, estabelecer desde o começo os princípios de suas pesquisas neurológicas. “A questão da privacidade deveria estar incluída no sistema desde o início” diz Chizeck. “Acho que se faz necessário um padrão – estabelecido por empresas do setor, entidades profissionais e o governo – com mecanismos a serem seguidos pelas empresas e supervisionados pelo governo ou agências independentes”, acrescenta.

Klein também considera importante que as empresas que desenvolvem tais projetos científicos pioneiros estabeleçam as regras do jogo com antecedência. “Elas precisam deixar claro de antemão quais são seus valores e a sua visão. É claro que o Facebook não pode prever tudo, mas, se deixarmos que o projeto seja guiado apenas pela tecnologia, a ética vai acabar ficando para trás”, diz.

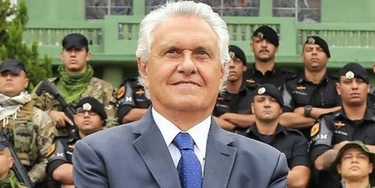

Foto do topo da página: O diretor executivo do Facebook, Mark Zuckerberg, no discurso de abertura da Conferência de Desenvolvedores – a F8 -, no McEnery Convention Center, em San Jose, na Califórnia, em 18 de abril de 2017.

Tradução: Bernardo Tonasse

Temos uma oportunidade, e ela pode ser a última:

Colocar Bolsonaro e seus comparsas das Forças Armadas atrás das grades.

Ninguém foi punido pela ditadura militar, e isso abriu caminho para uma nova tentativa de golpe em 2023. Agora que os responsáveis por essa trama são réus no STF — pela primeira e única vez — temos a chance de quebrar esse ciclo de impunidade!

Estamos fazendo nossa parte para mudar a história, investigando e expondo essa organização criminosa — e seu apoio é essencial durante o julgamento!

Precisamos de 800 novos doadores mensais até o final de abril para seguir produzindo reportagens decisivas para impedir o domínio da máquina bilionária da extrema direita. É a sua chance de mudar a história!

Torne-se um doador do Intercept Brasil e garanta que Bolsonaro e sua gangue golpista não tenham outra chance de atacar nossos direitos.