“E se a tecnologia pudesse ajudar a melhorar a conversa online?” sugere o site que apresenta o Perspective, uma ferramenta criada por pesquisadores do Google e da empresa-irmã Jigsaw para detectar automaticamente discurso de ódio online. A ideia é simples: usar aprendizado de máquina (machine learning, em inglês) para reconhecer conteúdos abusivos ou ameaças – e, assim, ajudar a promover conversas mais saudáveis nas redes sociais ou caixas de comentários.

Pesquisadores brasileiros, no entanto, descobriram que a tecnologia falha em entender o contexto ao analisar determinadas comunidades, como as drag queens. Por isso, se usada como forma de censura, pode funcionar exatamente a favor da propagação do discurso de ódio, silenciando as comunidades que mais sofrem com ela. Na prática, os brasileiros mostraram que o Perspective considera que os tuítes racistas de notórios supremacistas brancos são “conversas melhores” do que os palavrões e a exaltação à cultura gay de um perfil de uma drag queen.

O Perspective foi apresentado em 2017 pela Jigsaw, uma incubadora de projetos do grupo Alphabet (a empresa-mãe do grupo Google). A API pode ser conectada a outros sites, serviços e ser usada em diferentes plataformas interessadas em “hospedar conversas melhores”. Já há, por exemplo, um plugin do Chrome que usa o Perspective para silenciar comentários de ódio. Os jornais The Guardian e The New York Times também testaram a ferramenta para moderar automaticamente suas caixas de comentários. O sistema já está disponível em inglês, francês e espanhol.

O Perspective classifica em uma escala de 0% a 100% a probabilidade de um comentário ser tóxico – rude, desrespeitoso ou não razoável. A tecnologia foi treinada por usuários de internet que ranquearam comentários em uma escala entre “muito tóxico” e “muito saudável”. Com base na experiência humana, ela aprendeu o que costuma ser tóxico para humanos, e aplica automaticamente esses critérios ao analisar conteúdos.

Decididos a monitorar a eficácia da inteligência artificial, pesquisadores do InternetLab, instituto de pesquisa de internet e direito, criaram um programa que usa a API do Perspective para medir a toxicidade de tweets de drag queens e compará-los a perfis da extrema direita, notoriamente racistas e homofóbicos, e outras personalidades para controle. Para analisar o discurso das drag queens – grupo importante na discussão de identidade e papeis de gênero e com voz ativa na comunidade LGBTQ – eles escolheram as 80 participantes do programa RuPaul’s Drag Race. Para o teste, foram usados apenas tuítes em inglês – no total, 114 mil.

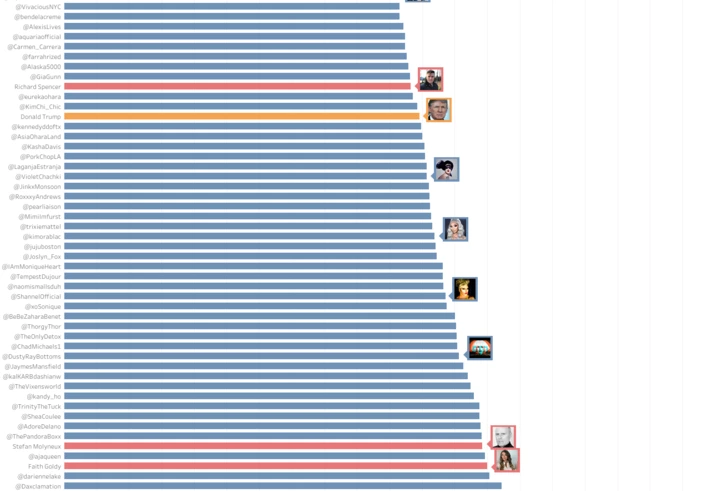

Os resultados, que ainda não foram divulgados na íntegra, mostram que, de maneira geral, os perfis das drag queens são considerados mais tóxicos do que os de supremacistas brancos: os primeiros chegam a 37,81% de toxicidade, enquanto o deles vai até 28,87%. Donald Trump, por exemplo, é considerado um perfil saudável. Seu nível de toxicidade é 21,84%.

Nível de toxicidade de diferentes perfis: em vermelho estão os supremacistas brancos e em azul as drag queens. Para controle, Donald Trump está em laranja e Michele Obama em verde.

Fonte: InternetLab

A equipe também testou palavras individualmente. “Bitch” – que pode ser usada como xingamento, como “puta” ou “vadia”, mas também pode ter conotação de exaltação feminina, por exemplo – é considerada 98,18% tóxica. “Gay”, 76,1%. E “lésbica”, 60,79%. “Isso significa que, independentemente do contexto, palavras como gay, lesbian e queer já são consideradas como significativamente tóxicas, o que aponta a existência de vieses no Perspective”, escreveram os pesquisadores.

Por outro lado, supremacistas brancos que usam uma linguagem polida no Twitter foram considerados saudáveis pela ferramenta. Stephen Moluyneux, youtuber conhecido por vomitar teorias racistas supostamente científicas, por exemplo, tuitou que “as três maiores raças têm diferentes volumes cerebrais e médias de QIs”. Nível de toxicidade? Só 21%, segundo o Perspective.

O impacto nas comunidades vítimas do ódio

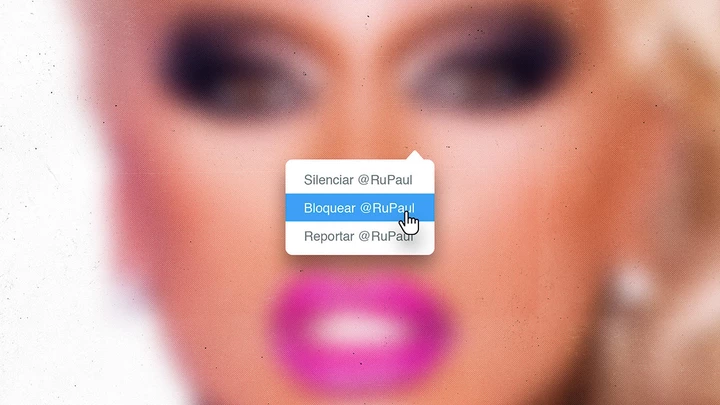

Quando os pesquisadores testaram o Tune, um plugin para o Chrome que usa o Perspective para suprimir conteúdo tóxico online, eles perceberam como esse tipo de classificação pode funcionar, na prática, para suprimir o discurso e censurar determinadas comunidades. Lançado em março, o Tune permite que os usuários escondam comentários tóxicos no YouTube, Twitter e Facebook, regulados por uma espécie de “volume”.

O mais baixo é o “modo zen”, em que os comentários classificados como abusivos são substituídos por pontinhos na tela. A ideia, segundo a empresa, é permitir que os usuários “foquem no que importa”.

Neste modo, os pesquisadores perceberam que o perfil da drag Yuhua Hamasaki, que participou da décima temporada de Ru Paul’s Drag Race, fica assim:

“Quando considerados individualmente, 3.925 tweets das drag queens tiveram seu potencial de toxicidade avaliado em 80% ou mais, o que significaria que ficariam todos ocultados de usuários do Tune”, explicam os pesquisadores.

Terceirizando a decisão para robôs

Nós já explicamos como a lógica das plataformas de internet estimula que conteúdos que despertem raiva se espalhem – e como elas têm se tornado um celeiro para conteúdos de extrema direita. Conteúdos de ódio estão entre os mais denunciados na SaferNet, organização não-governamental que combate violações de direitos humanos na internet, e o número de denúncias só cresce.

As grandes empresas de internet sabem que têm um problema sério – e as iniciativas de inteligência artificial são uma tentativa de combatê-lo em larga escala, além de mostrar para autoridades e para o público que elas estão agindo. Só que manifestações de racismo, homofobia, machismo e ameaças muitas vezes dependem de uma análise contextual para serem detectadas – e cada grupo tem um modo específico de falar, o que dificulta a análise. Se é difícil para seres humanos classificarem, para robôs é ainda pior. “Essas tecnologias não são plenamente capazes de reconhecer o contexto e discernir quando um conteúdo é legítimo”, diz Dennys Antonialli, diretor-executivo do InternetLab e um dos pesquisadores envolvidos.

‘Na medida em que pessoas negras ou LGBTQs desenvolverem tecnologia, elas terão mais sensibilidade para essas questões.’

Em relação ao discurso LGBTQ analisado pelos brasileiros, a tecnologia falha em captar o diferente significado de palavras consideradas tóxicas quando usadas por membros da comunidade queer. As drags queens costumam usar expressões chulas ou têm uma linguagem mais dura justamente porque, como personalidades públicas, estão na linha de frente e precisam se posicionar como estratégia de sobrevivência ou aceitação. É claro que um robô não entende isso – especialmente se ele foi feito ou treinado por seres humanos que também não entendem. “Elas acabam usando um banco de dados que muitas vezes estão recheados e viciados com vários vieses. E reforçam preconceitos”, diz Antonialli.

Enquanto isso, discursos racistas são aprovados pelos robôs quando não digitados com palavrões e expressões que podem ser consideradas agressivas em alguns ambientes. As máquinas ainda não entendem que ideias escritas de forma elegante também podem ser extremamente tóxicas.

É o mesmo caso, por exemplo, das ferramentas de reconhecimento facial. O fato de elas serem muito mais eficientes para identificarem homens brancos do que mulheres negras não é por acaso – é reflexo de como elas foram feitas e treinadas.“Os algoritmos são treinados. Ter diversidade e pluralidade para que esses bancos tenham menos vieses é super importante. Olhar pra quais são os dados que estão treinando a inteligência artificial é uma primeira questão sensível”, diz Antonialli.

A outra, para ele, é no desenvolvimento. Uma equipe diversificada permite encontrar esses vieses e corrigi-los, dando mais ou menos peso para um dado. Um programador LGBTQ, por exemplo, poderia interferir na carga de toxicidade atribuída à palavra “gay” ou “lésbica”. “Na medida em que pessoas negras ou LGBTQs desenvolverem tecnologia, elas terão mais sensibilidade para essas questões.”

A Jigsaw, por meio da assessoria de imprensa do Google no Brasil, disse que não comentará a pesquisa.

Temos uma oportunidade, e ela pode ser a última:

Colocar Bolsonaro e seus comparsas das Forças Armadas atrás das grades.

Ninguém foi punido pela ditadura militar, e isso abriu caminho para uma nova tentativa de golpe em 2023. Agora que os responsáveis por essa trama são réus no STF — pela primeira e única vez — temos a chance de quebrar esse ciclo de impunidade!

Estamos fazendo nossa parte para mudar a história, investigando e expondo essa organização criminosa — e seu apoio é essencial durante o julgamento!

Precisamos de 800 novos doadores mensais até o final de abril para seguir produzindo reportagens decisivas para impedir o domínio da máquina bilionária da extrema direita. É a sua chance de mudar a história!

Torne-se um doador do Intercept Brasil e garanta que Bolsonaro e sua gangue golpista não tenham outra chance de atacar nossos direitos.